Olá Pessoal!

Você sabia que pode implantar o InterSystems IRIS Community Edition na nuvem sem pagar por uma licença? Você pode experimentar gratuitamente, e pode até ser útil se quiser exibir aquele novo aplicativo brilhante que você criou (talvez para a competição full stack..? )

Neste artigo, fornecerei um passo a passo completo sobre como implantar o IRIS na Amazon Web Services (AWS), e também adicionarei um acompanhamento para a implantação no Azure.

Agora, antes de começar o passo a passo, quero admitir que fiquei apavorado ao usar a AWS pela primeira vez porque vi memes sobre como é fácil acumular custos na AWS. Então, se você está pensando o mesmo, sugiro que comece inscrevendo-se em uma Conta de Nível Gratuito, que lhe dá $100 de crédito gratuito para avaliar, e desliga automaticamente para evitar cobranças. O InterSystems IRIS Community Edition tem uma licença gratuita, então se você emparelhar os dois, pode implantar sem risco e totalmente de graça. (Aviso: embora eu tenha certeza de que isso é verdade, por favor, leia os termos da conta gratuita e tome suas próprias decisões 😅 )

Passo a passo

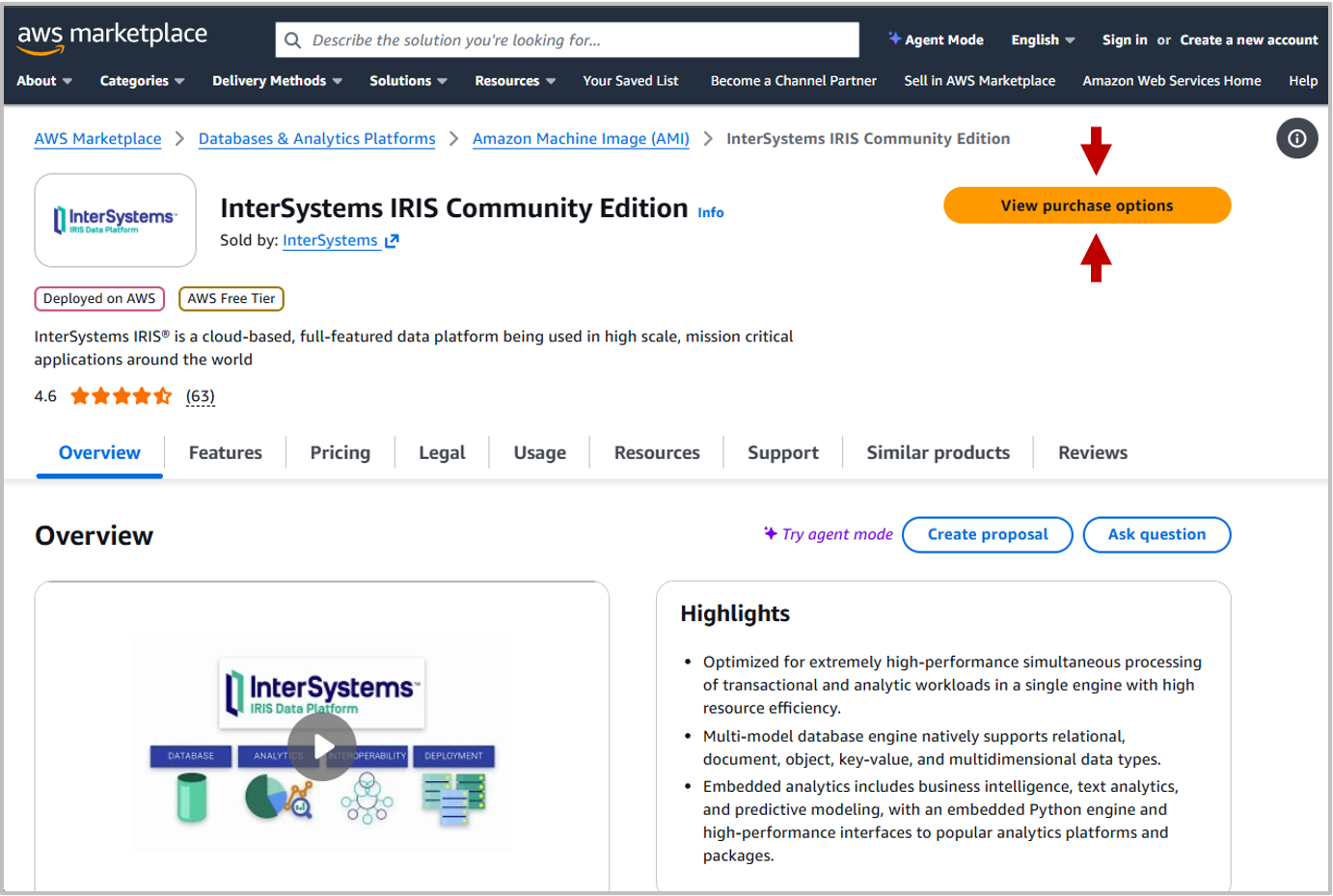

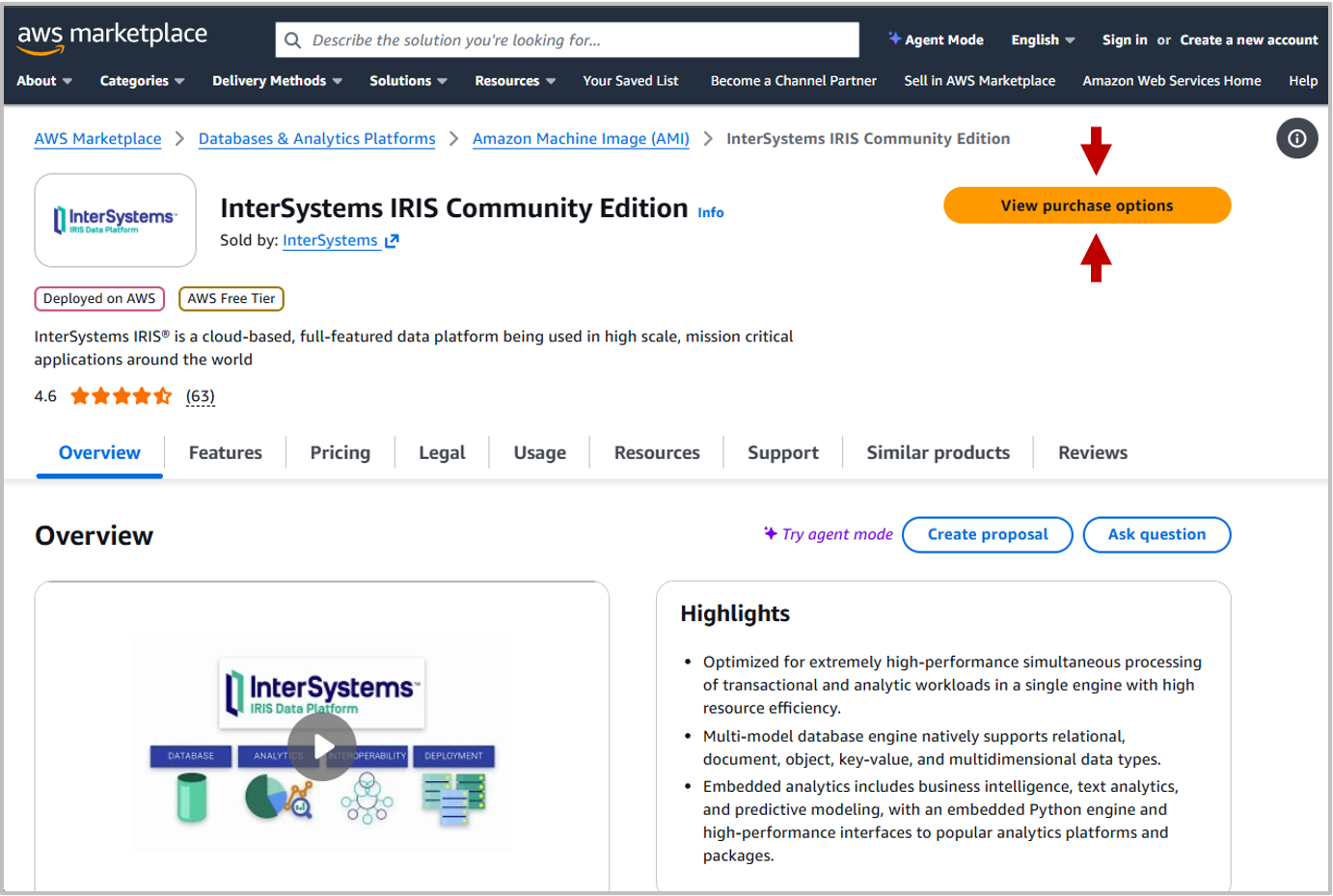

Uma vez conectado na AWS vá para InterSystems IRIS Community Edition no AWS Marketplace.

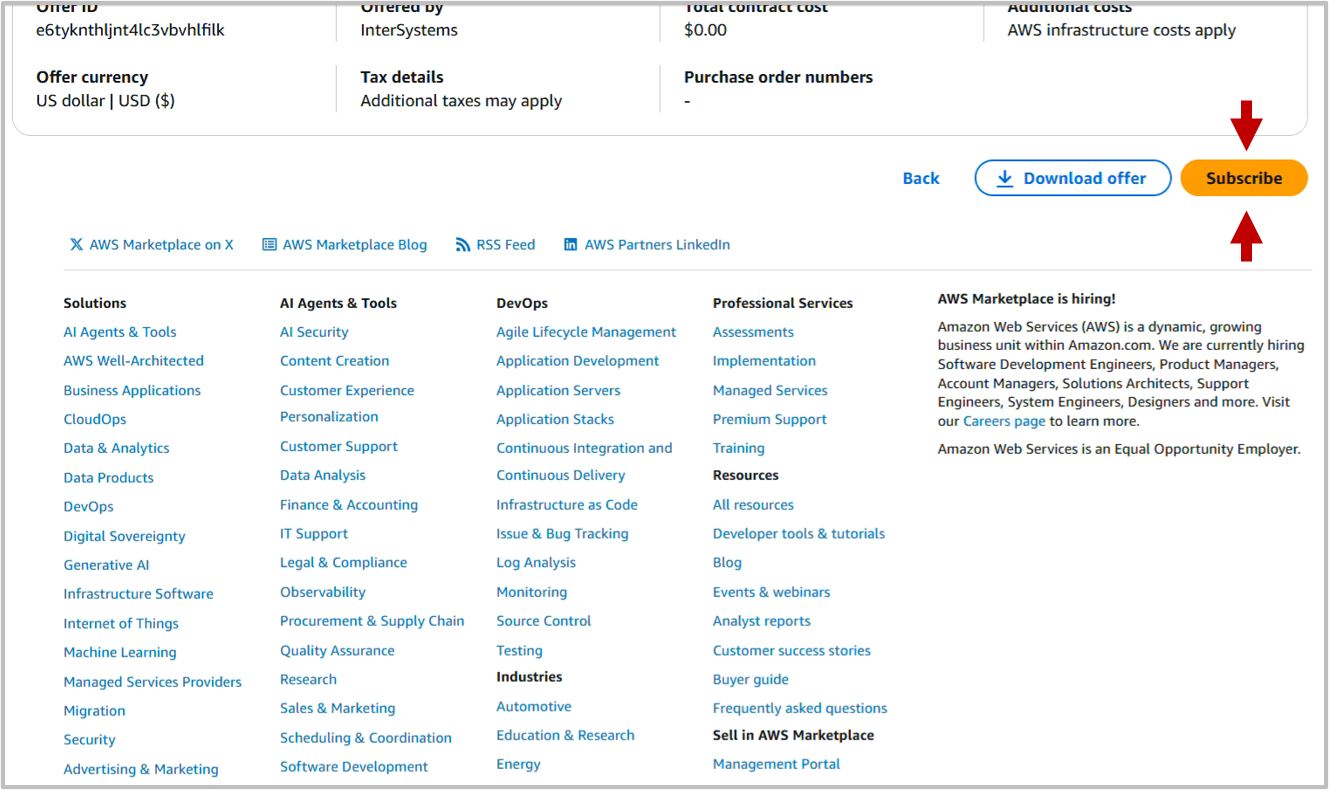

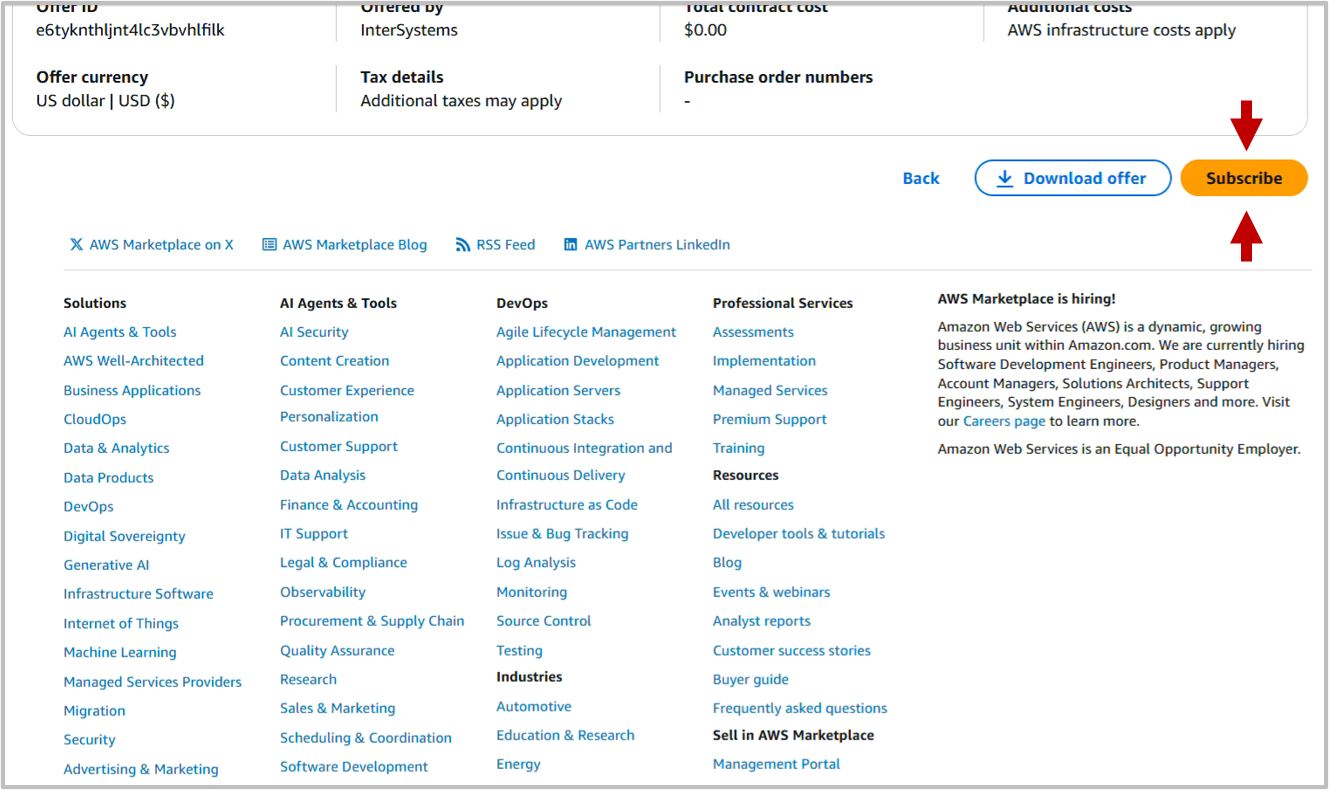

Clique em View Purchase Options para ver a página "Subscribe to InterSystems IRIS Community Edition". Esta página inclui Termos e Condições, juntamente com detalhes de preços, que mostram o valor Total como $0.00. Role até o final da página e clique em Subscribe:

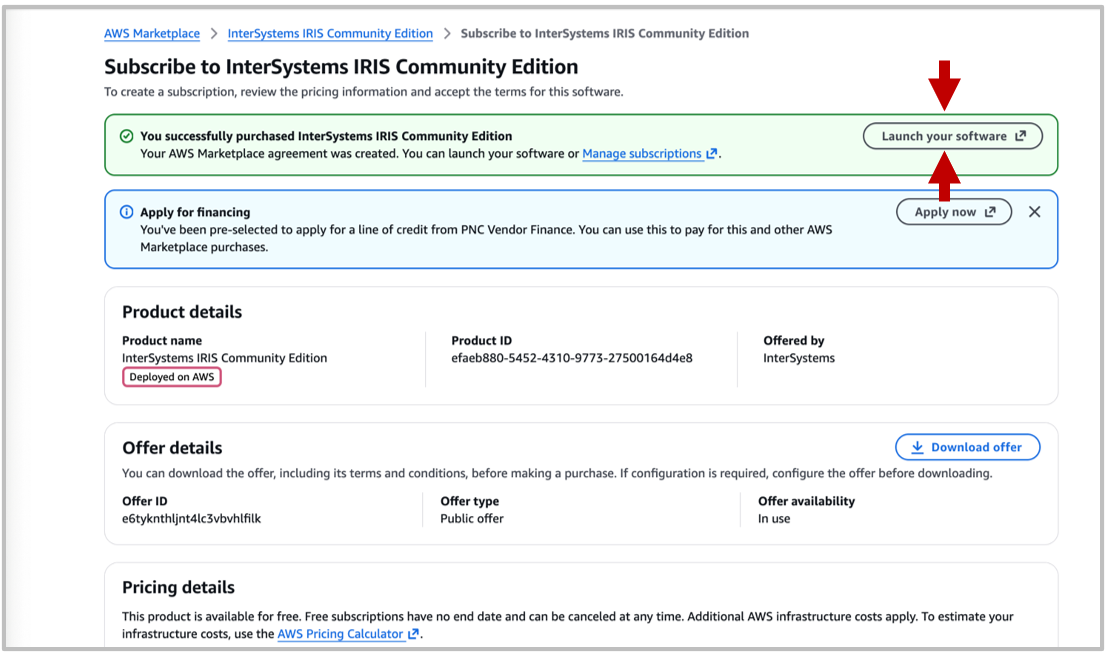

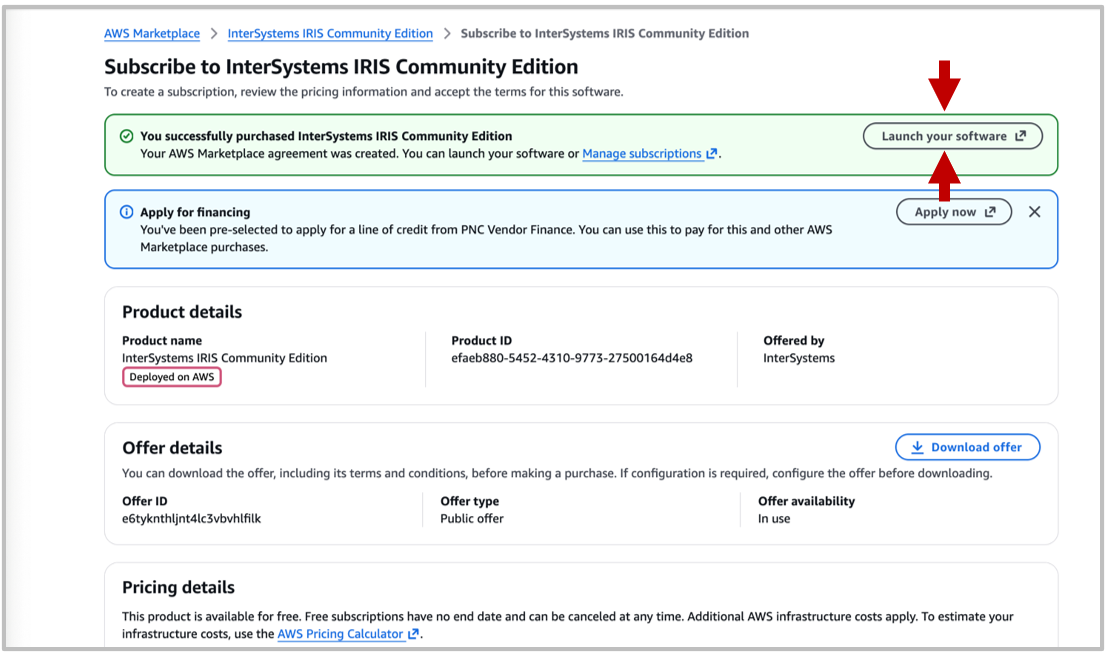

Pode levar um minuto para processar a Assinatura. Depois, você será redirecionado para uma página que inclui as informações da assinatura e um botão dizendo "Launch your software". Note que a localização exata deste botão na página varia.

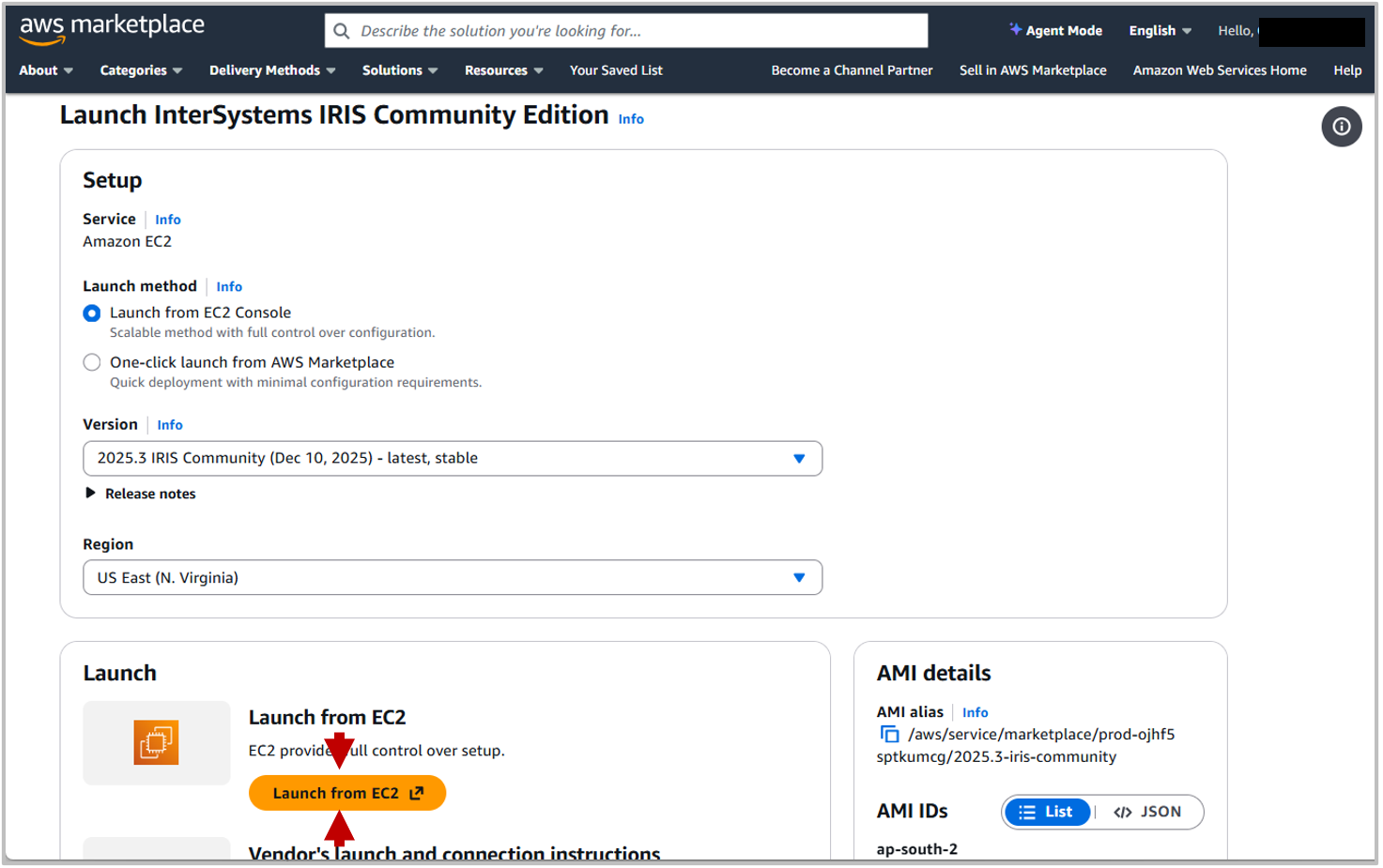

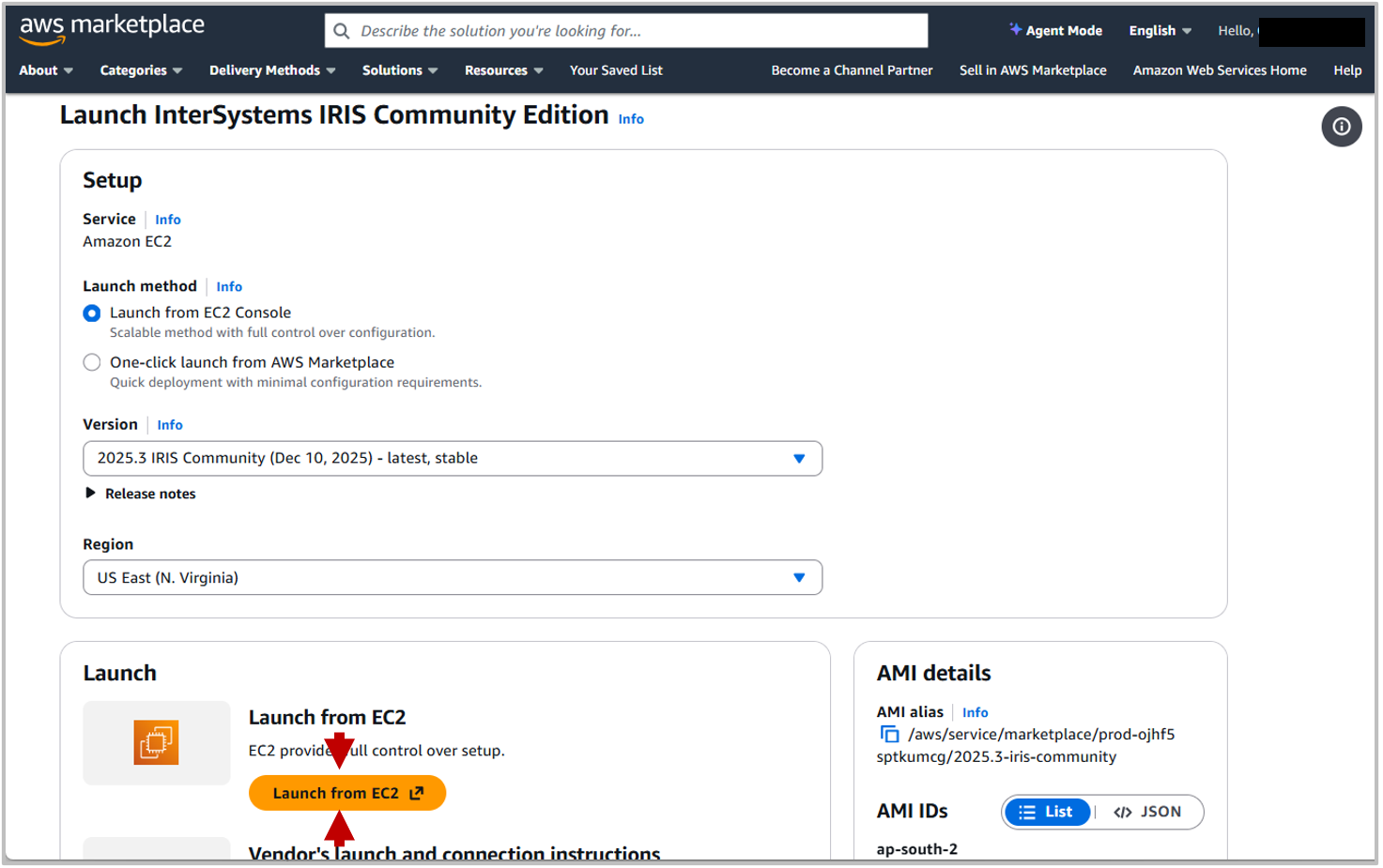

A partir daqui você pode selecionar sua configuração de lançamento e definições:

Se você não está familiarizado com o lançamento na AWS, é recomendado usar o EC2 Launch Console. Selecione isso no Launch Method e depois clique em Launch from EC2.

Console de Lançamento EC2

O console de Lançamento EC2 é onde você define as configurações para a Instância que você está iniciando. Você pode querer explorar essas configurações com mais detalhes por conta própria, mas este guia descreverá algumas das configurações principais.

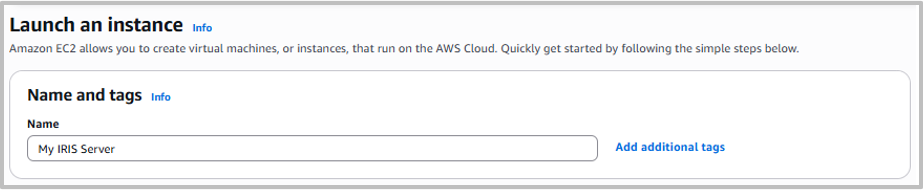

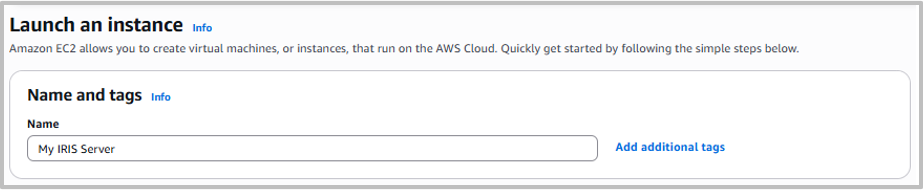

Nome e Tags

Estes são usados para reconhecer e identificar a Instância. A nomeação e marcação organizadas são especialmente importantes se você estiver gerenciando múltiplas instâncias da AWS.

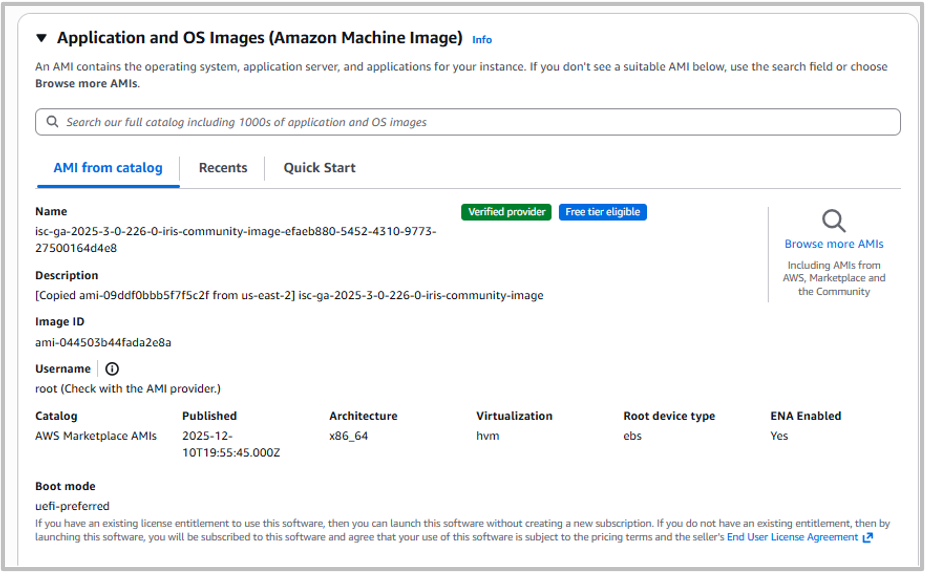

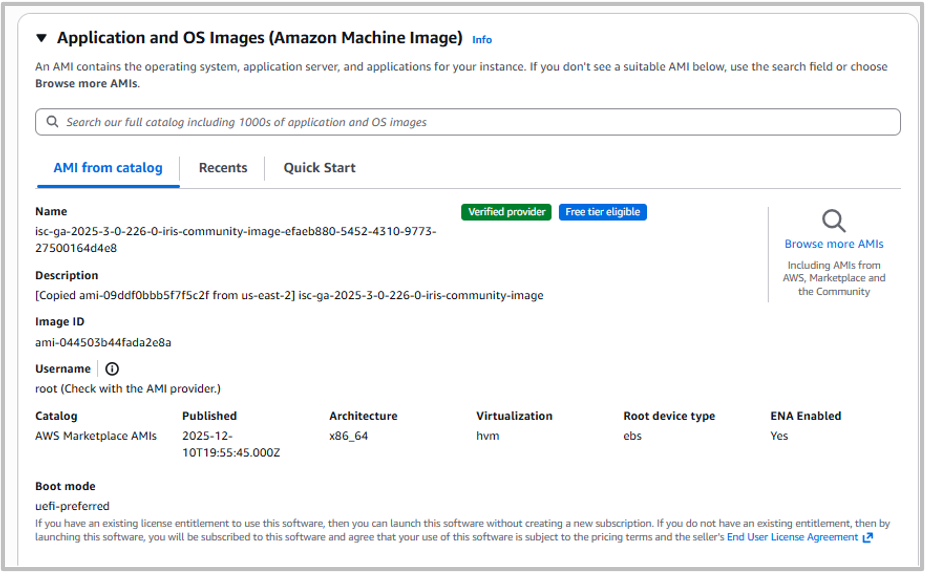

Imagens de Aplicativo e SO (Amazon Machine Image)

É aqui que você seleciona a máquina virtual sendo executada. Se você clicou através da página do marketplace do InterSystems IRIS Community Edition, você já deve ter a Amazon Machine Image (AMI) correta selecionada. Caso contrário, você pode selecioná-la no catálogo.

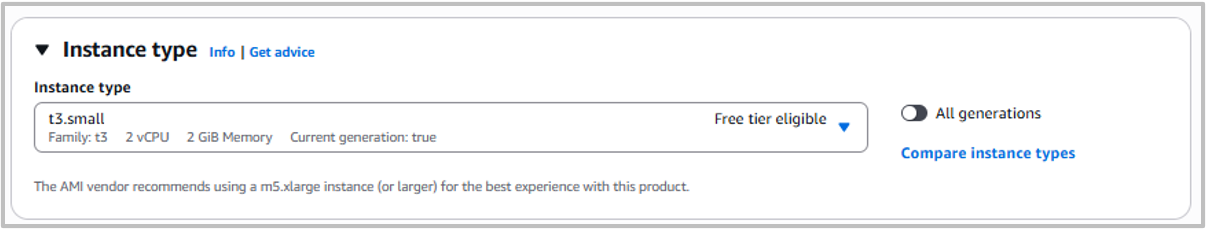

Tipo de Instância

Este é o hardware no qual o InterSystems IRIS Community Edition será executado. Se você for membro do nível gratuito, estará limitado a máquinas pequenas aqui. Escolha sua máquina com base tanto no tamanho da carga de trabalho quanto no orçamento, pois máquinas mais potentes terão um custo maior.

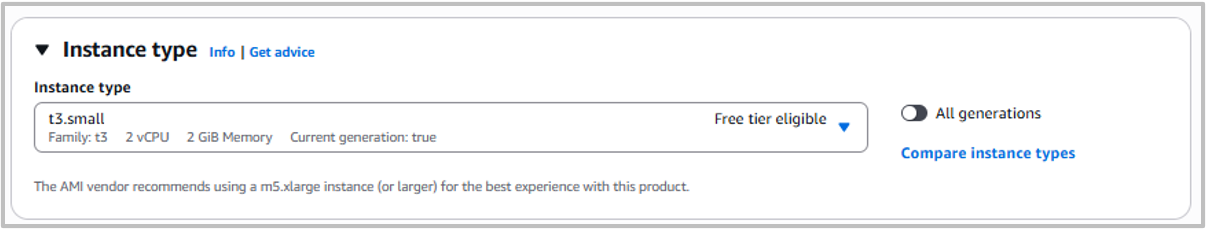

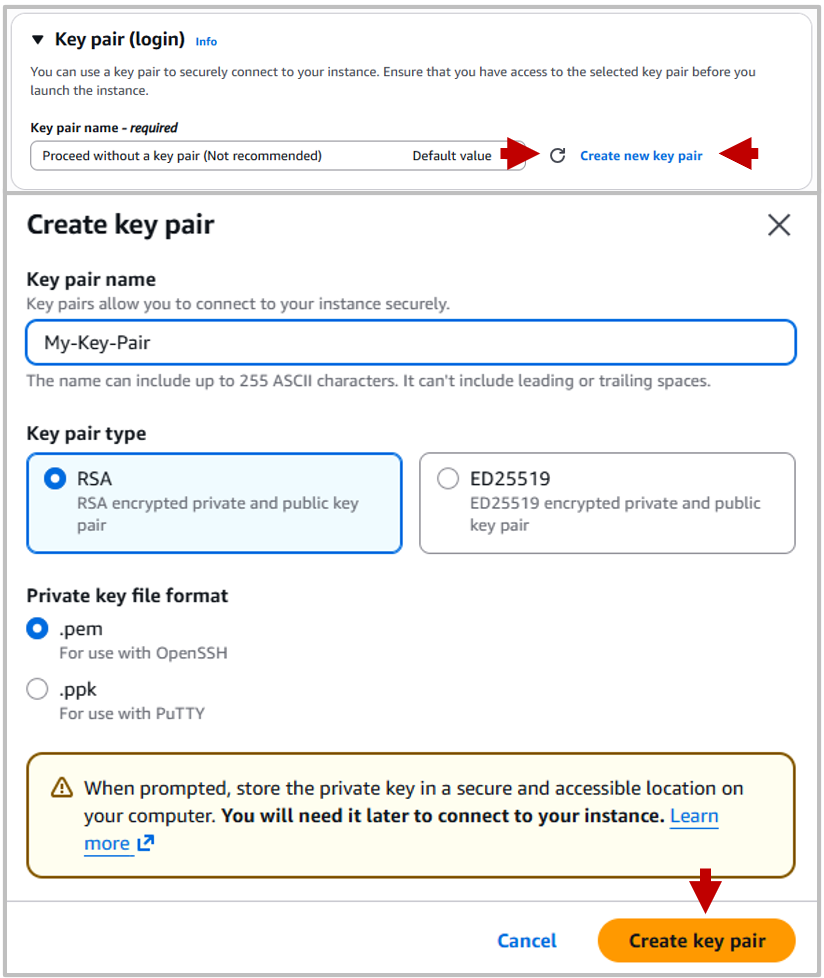

Par de Chaves (Login)

O par de chaves é a chave de login que você pode usar para se conectar à instância através de uma conexão Secure Shell (SSH). Se você não decidir um par de chaves aqui, não poderá fazer login via SSH.

Então, crie um par de chaves, isso permite logins SSH seguros, isso fará o download de uma Chave Privada que você pode usar para fazer login.

A menos que você tenha criado anteriormente um par de chaves, precisará gerar um novo. Para isso, clique em Create new key pair, e no pop-up escolha um nome de chave (para identificá-la), um método de criptografia e um formato de arquivo (se não tiver certeza sobre estes, deixe-os como padrão).

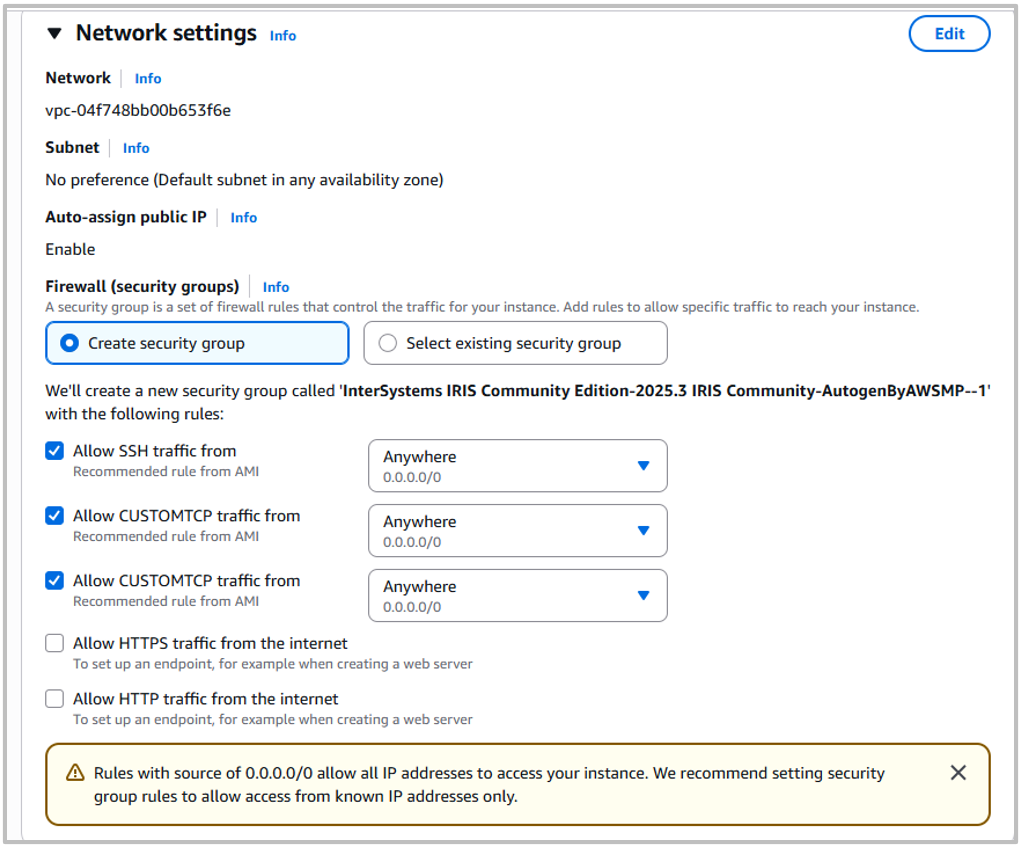

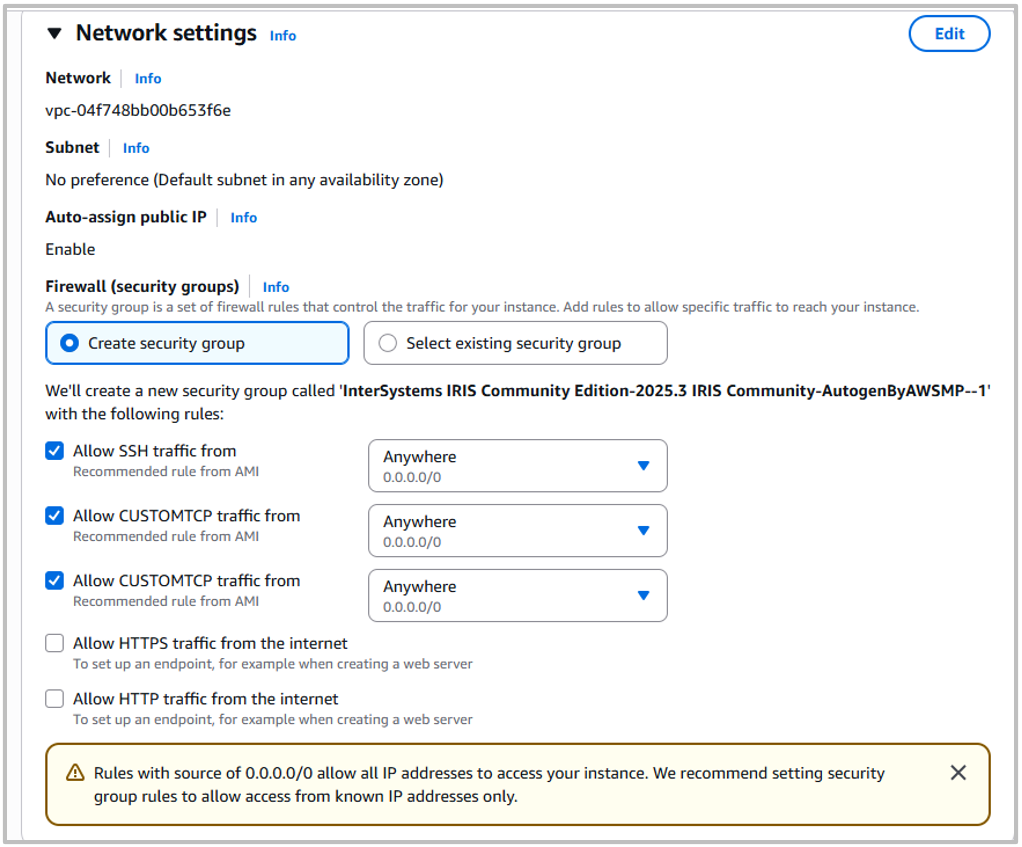

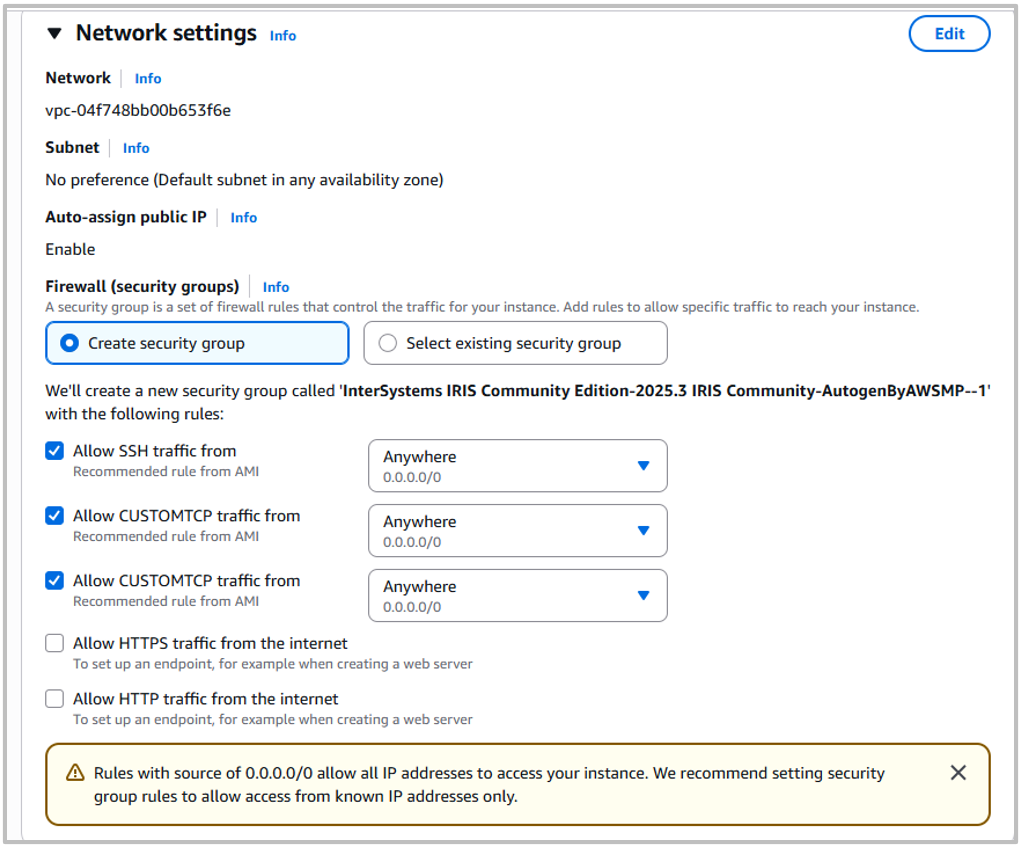

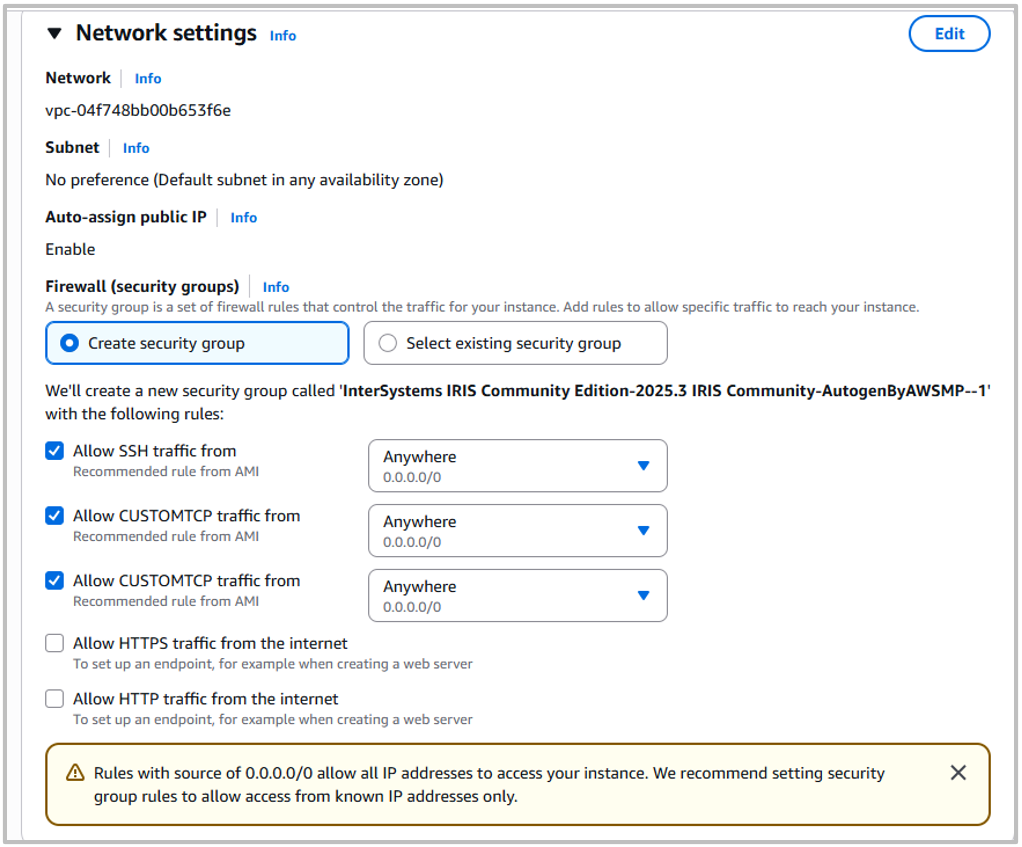

Configurações de Rede

Aqui você pode definir algumas configurações de Segurança de Rede, como limitar quais endereços IP podem se conectar à sua instância e permitir tráfego HTTP/HTTPS. Dependendo do seu caso de uso e preocupações de segurança, as configurações apropriadas variarão, então considere as configurações necessárias para o uso desejado.

Armazenamento

Escolha a quantidade de armazenamento necessária para sua instância. Note que o InterSystems IRIS Community Edition limita o armazenamento do banco de dados a 10GB, então é improvável que seja necessário significativamente mais do que isso.

Detalhes Avançados

Há um grande número de configurações adicionais disponíveis, incluindo a capacidade de fazer upload de dados do usuário do portal de lançamento. Estas podem ser ignoradas para uso básico.

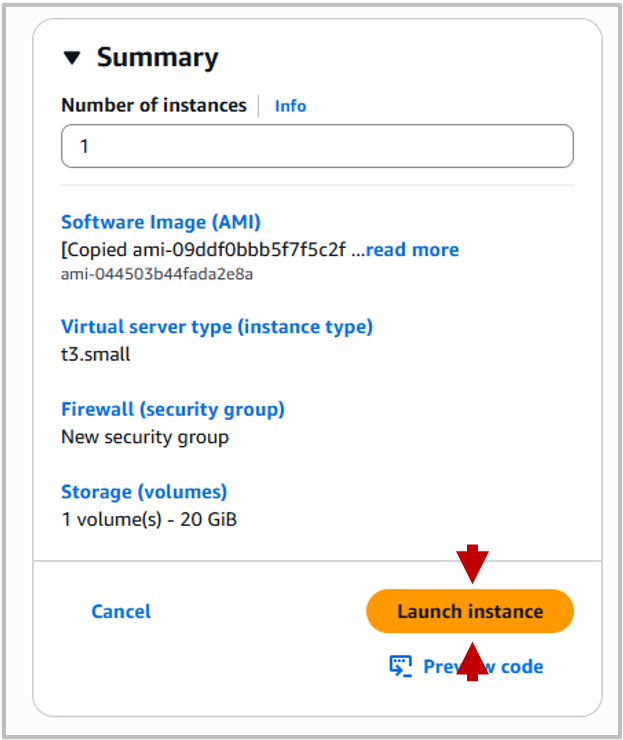

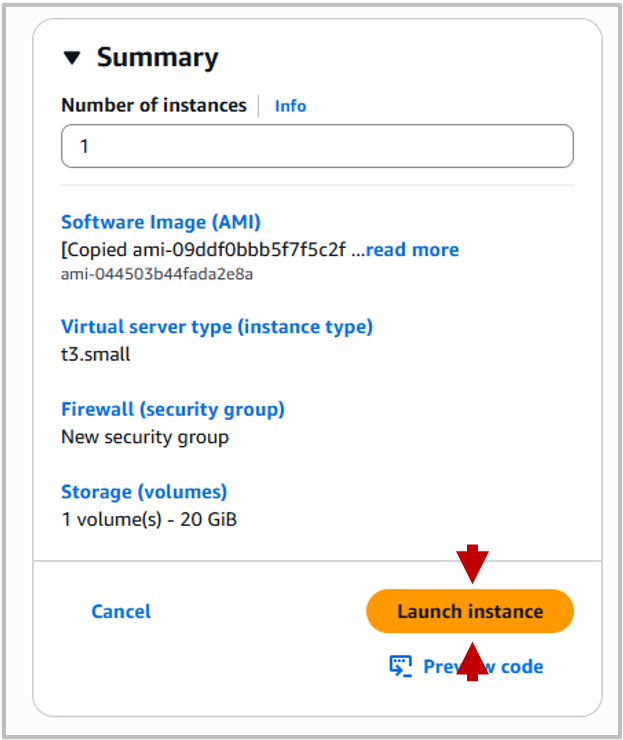

Iniciar Instância

Após selecionar suas configurações, clique em Launch Instance no painel Summary no lado direito da página.

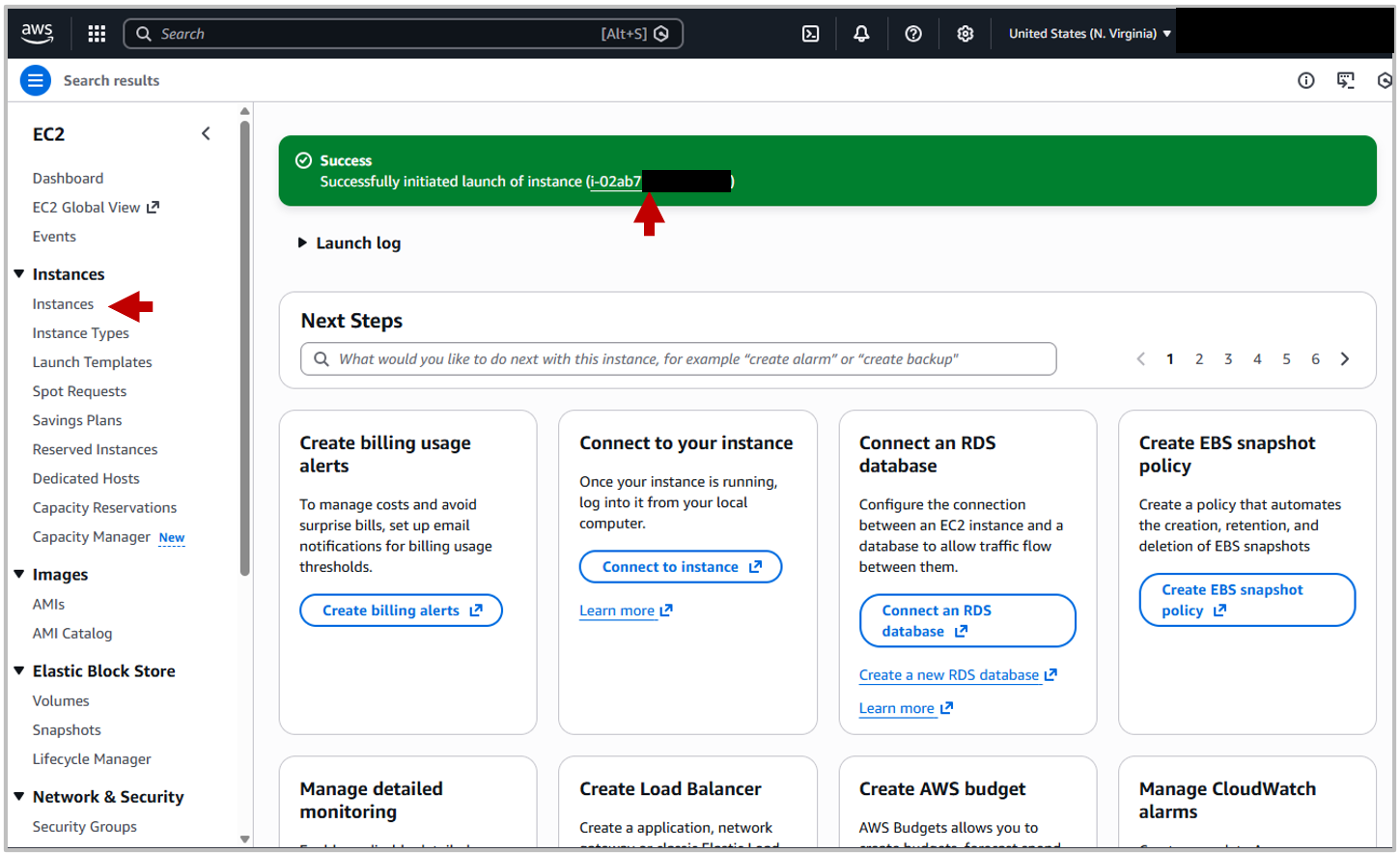

Sua instância levará um pouco de tempo para iniciar e fazer os testes de status apropriados, mas depois disso estará disponível online.

Conectar

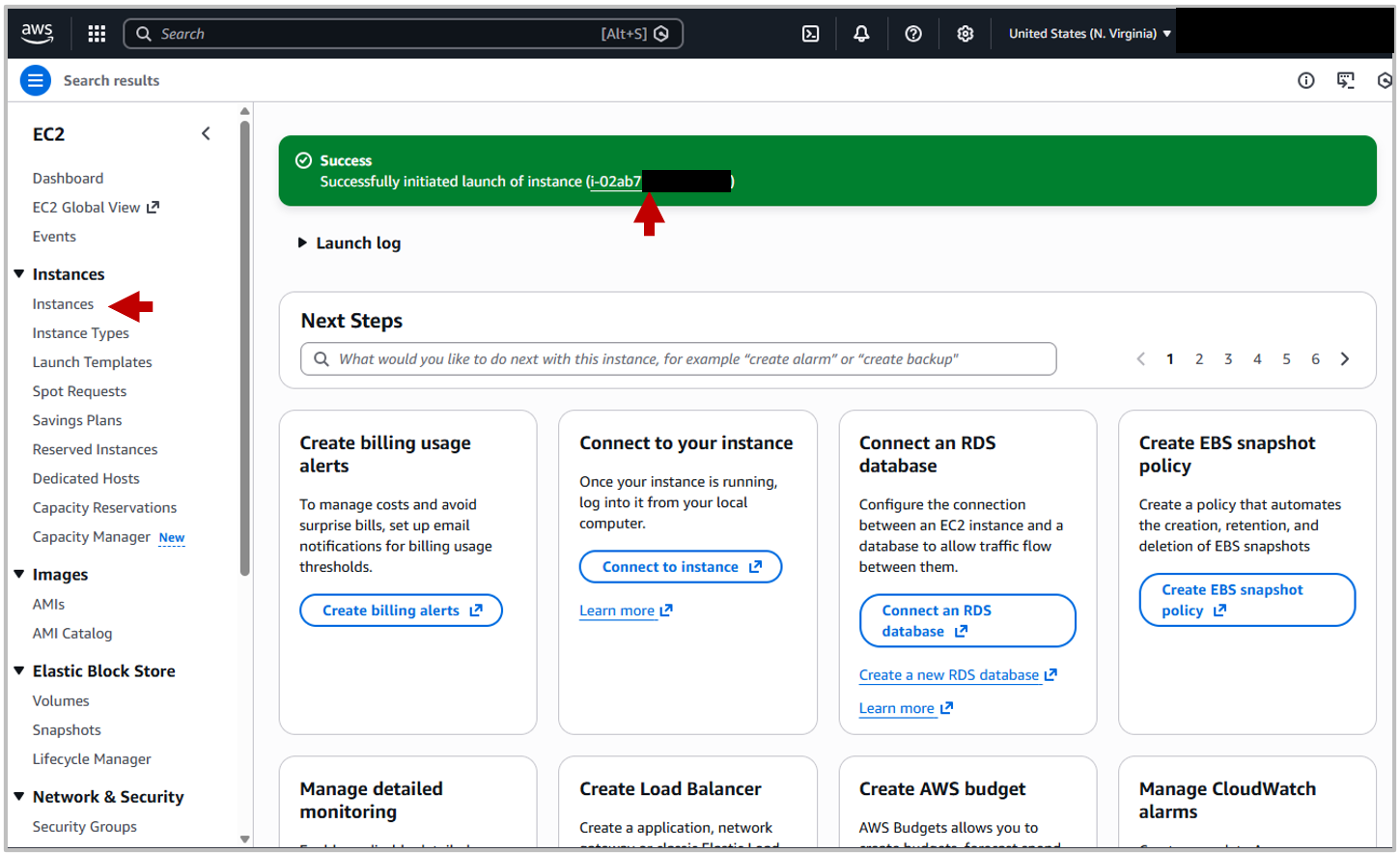

Depois de iniciar sua instância, você pode navegar para o resumo da instância selecionando o ID dentro da mensagem de sucesso ou navegando para o painel de instances no painel esquerdo.

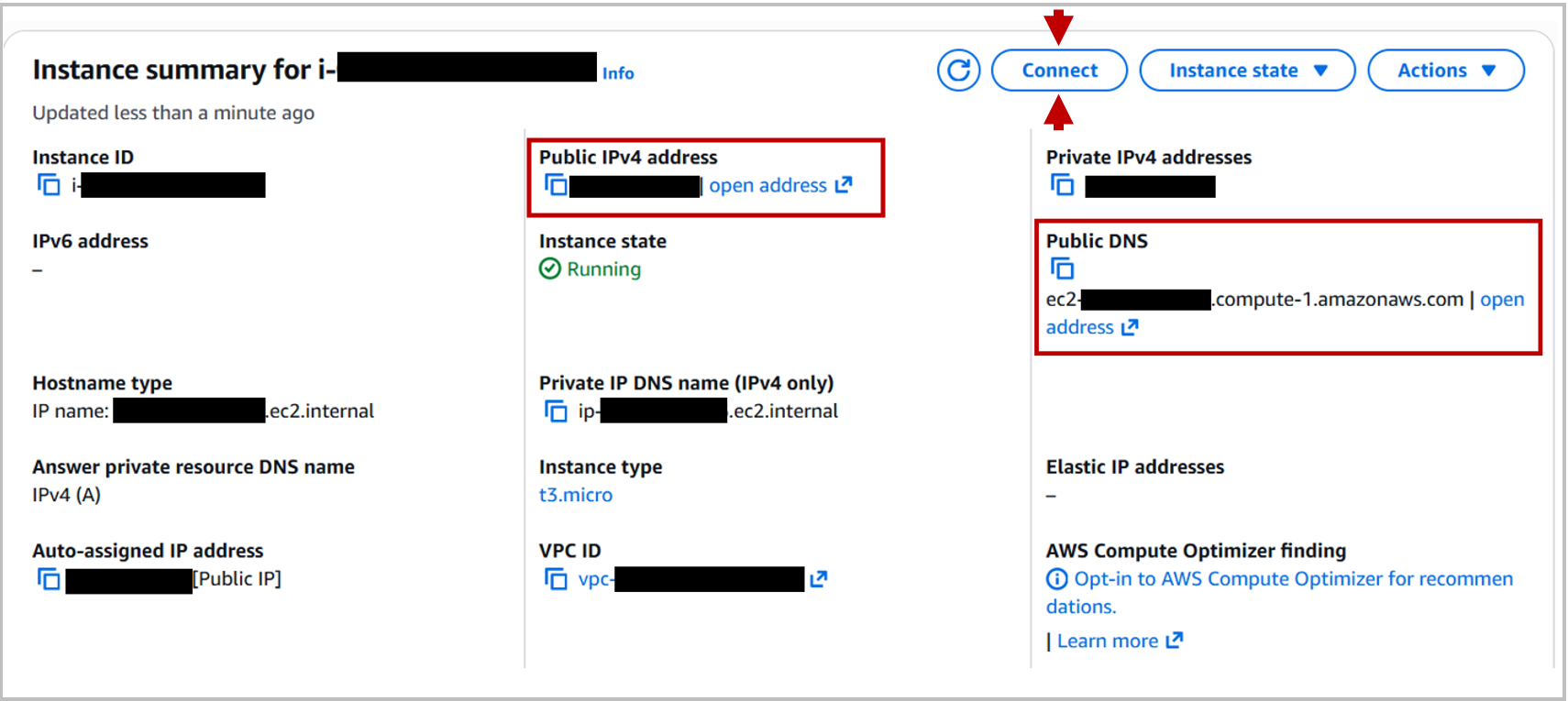

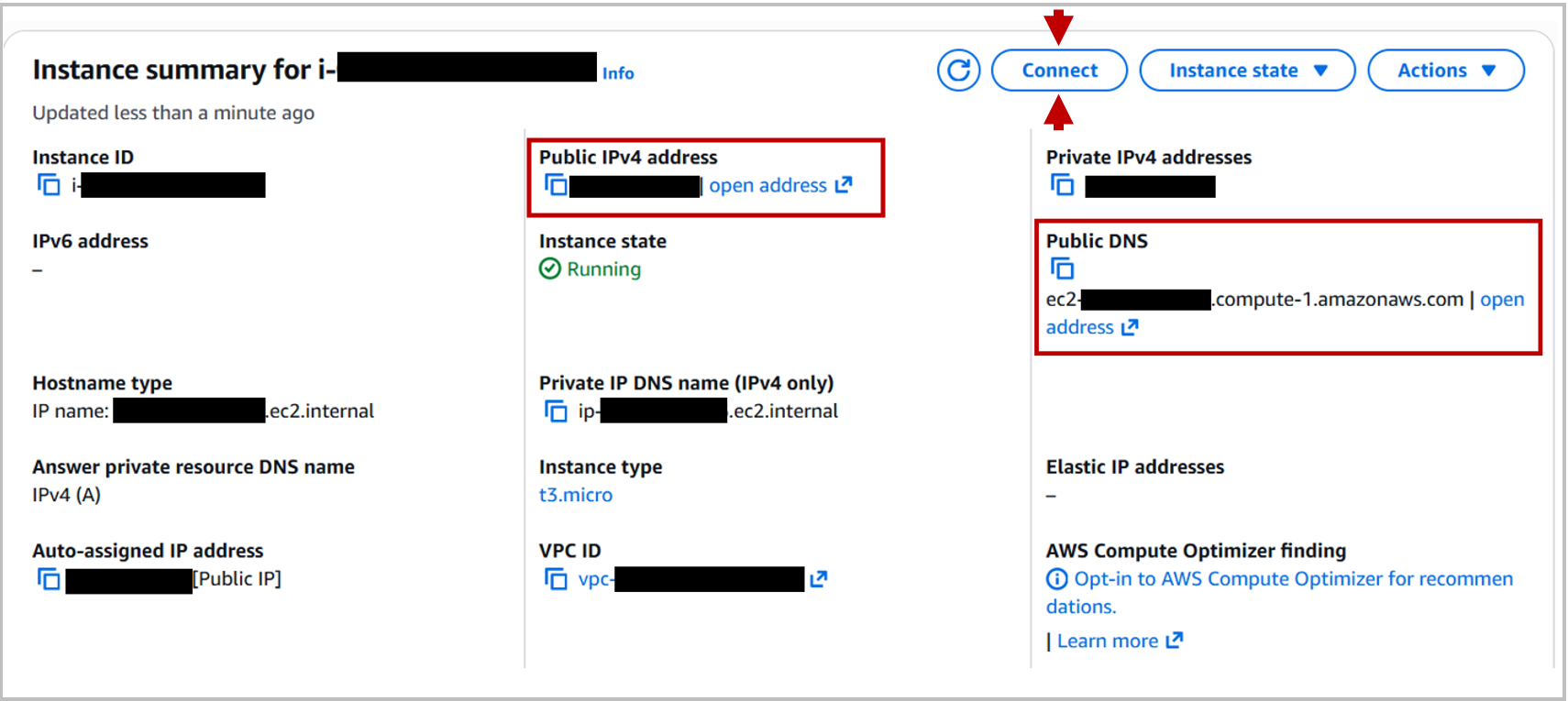

A partir do Resumo da Instância, você pode encontrar o Public IPv4 address e o Public DNS, qualquer um dos quais pode ser usado para se conectar à instância com SSH ou como um servidor web. O DNS Público é um redirecionamento que roteia para o endereço IP, então cada opção tem o mesmo resultado.

Você pode se conectar à instância de diferentes maneiras, algumas das quais são descritas abaixo.

Qualquer que seja o método de conexão que você usar, precisará redefinir a senha na primeira vez que se conectar. As credenciais padrão são:

- Nome de usuário: _SYSTEM

- Senha: SYS

Se você estiver se conectando a partir de uma interface de linha de comando, altere a senha com:

iris password

e inicie um terminal IRIS com:

iris session iris

Note que, toda vez que você abre uma nova conexão de terminal, a mensagem de entrada incluirá um lembrete para alterar sua senha, mas isso é necessário apenas uma vez.

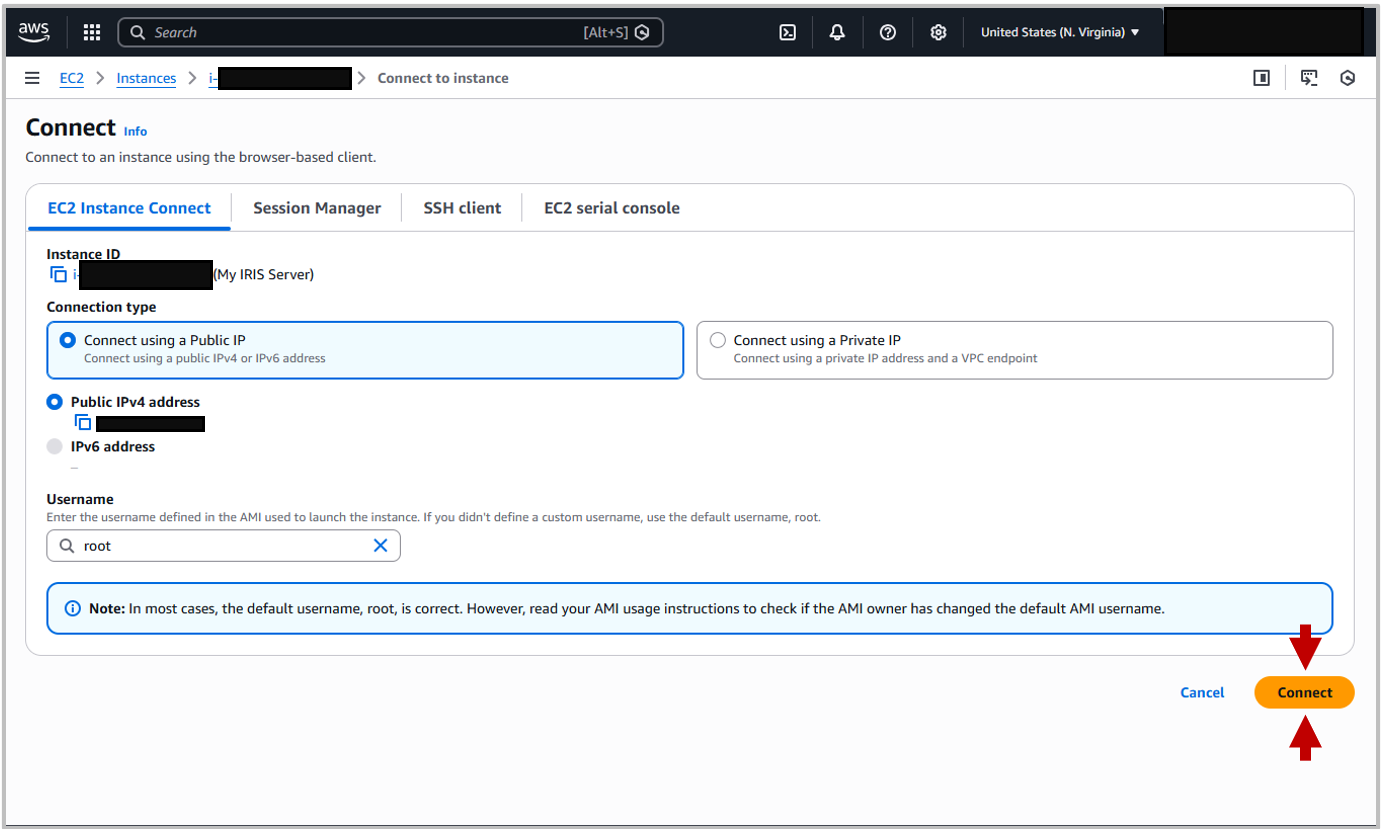

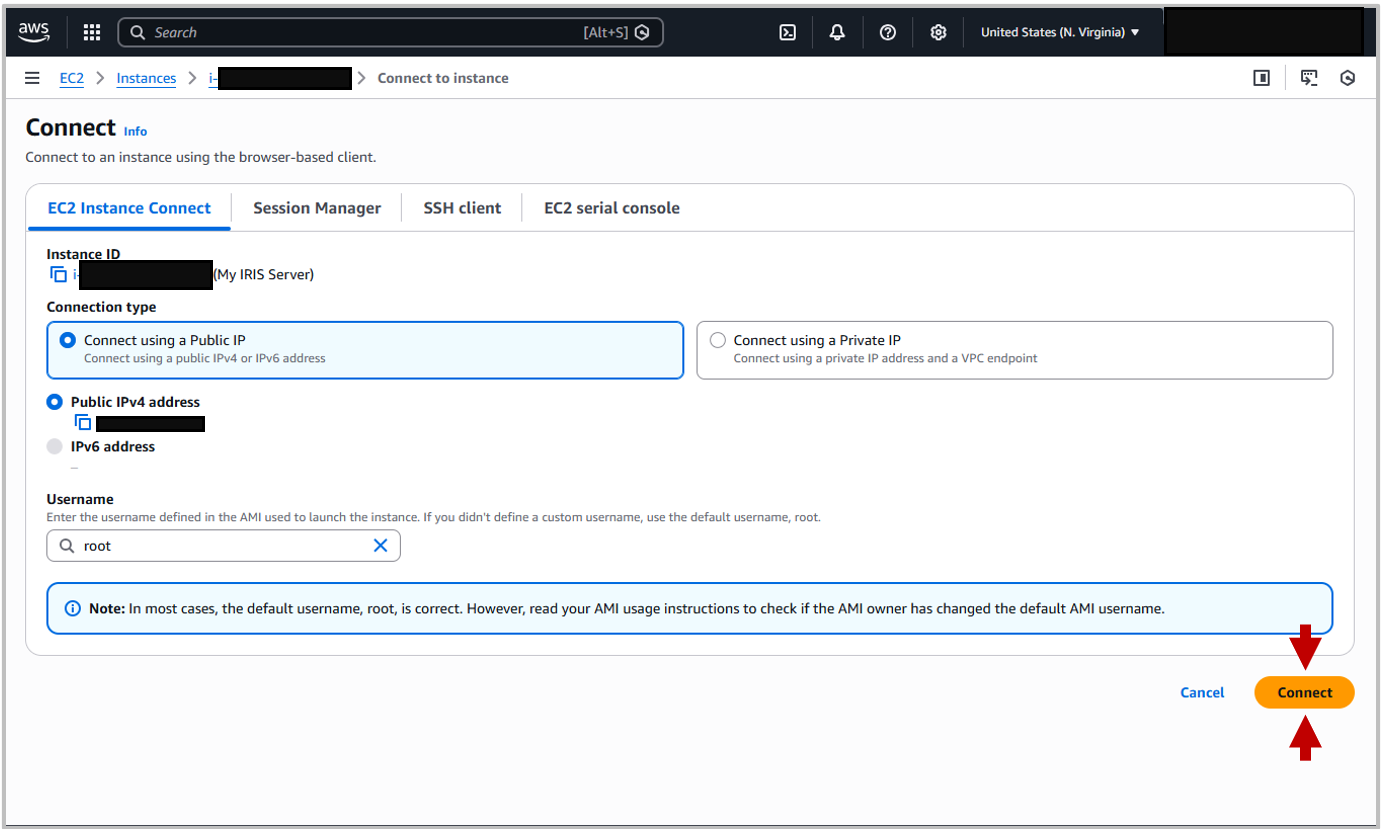

Conexão de Instância EC2

No painel da Instância há um botão grande dentro do resumo da instância para Connect (veja a captura de tela acima). Clique nele para abrir o portal de conexão. A primeira guia disto é a guia EC2 Instance Connect . Você pode deixar os padrões no lugar e clicar em Connect. Isso abrirá uma nova janela de terminal.

Cliente SSH

Você pode se conectar usando SSH, usando a chave Privada baixada anteriormente e os endereços IP ou DNS listados sob o resumo da instância. Por favor note, ao se conectar à sua instância InterSystems IRIS usando SSH, você precisa usar o nome de usuário ubuntu.

Você pode usar uma conexão SSH para copiar arquivos para sua instância usando scp, sftp ou um cliente SFTP como o FileZilla. Para qualquer um destes, você precisará usar seu arquivo de identidade como uma chave e "ubuntu" como o nome de usuário.

Portal de Gerenciamento

Você deve ser capaz de acessar o Portal de Gerenciamento nos endereços DNS ou IP listados, a menos que as configurações de segurança que você selecionou restrinjam isso. Para acessar o Portal de Gerenciamento, anexe :52773/csp/sys/%25CSP.Portal.Home.zen ao endereço IP ou DNS e abra em seu navegador. i.e.

<u>http://ec2-xx-xx-xxx-xxx.compute-1.amazonaws.com:52773/csp/sys/%25CSP.Po... ou <u>xx.xx.xxx.xxx:52773/csp/sys/%25CSP.Portal.Home.zen</u>

Onde os valores x são o endereço IP do servidor.

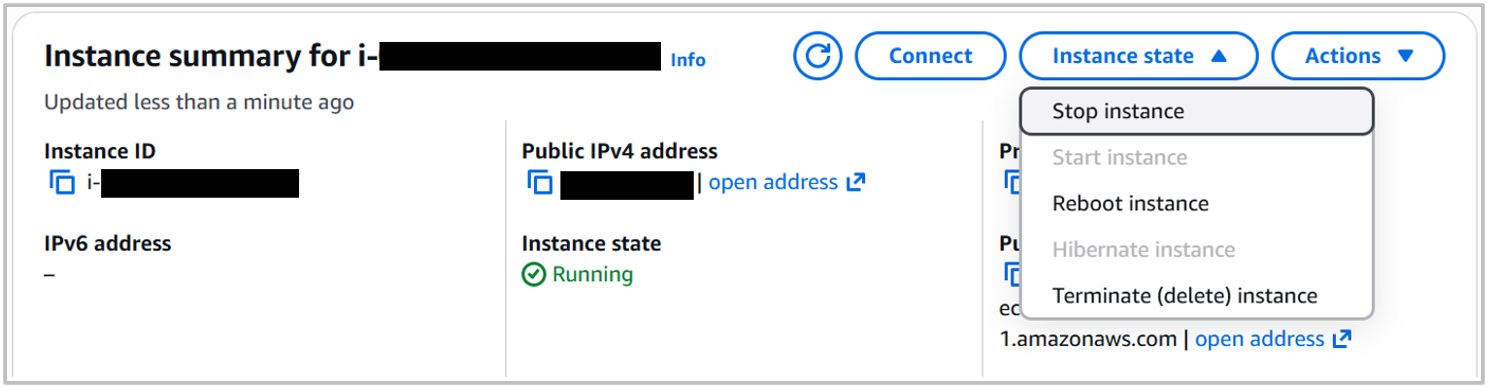

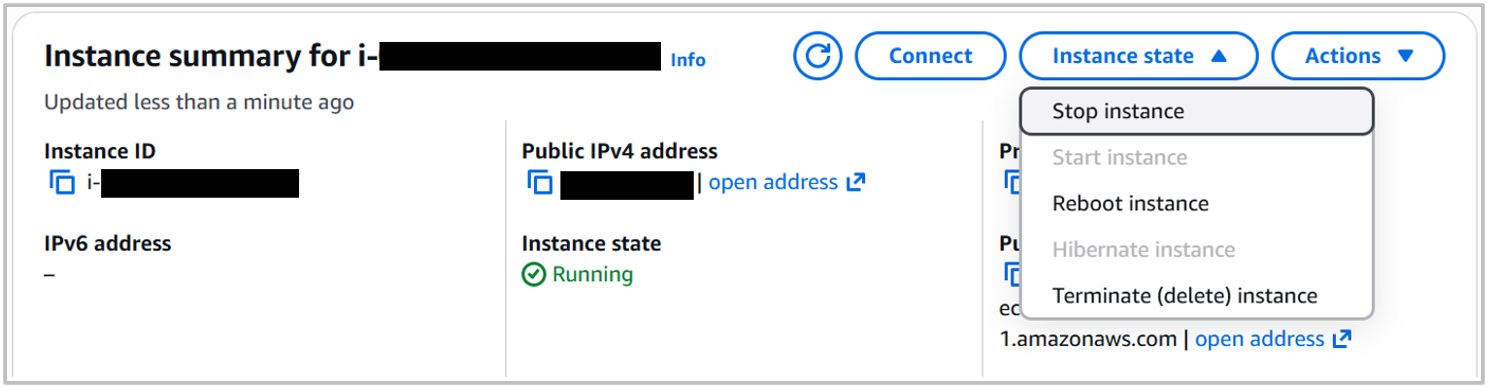

Encerrar Instância

Quando você tiver terminado de trabalhar com sua instância InterSystems IRIS Community Edition e não quiser mais a demonstração online, considere encerrá-la para evitar cobranças excessivas. Você pode fazer isso no Portal de Instâncias:

E aí está! Esse é o guia de hoje sobre como implantar o InterSystems IRIS Community Edition na Nuvem com a AWS

.png)

.png)

.png)

.png)