これは、InterSystems FAQサイトの記事です。

各プロセスが消費しているメモリの内容は、Windowsリソースモニタの項目のワーキングセット、共有可能、プライベートで確認できます。

これらの内容は以下になります。

ワーキングセット プロセスが使用する物理メモリです。

ワーキングセット(プライベート)とワーキングセット(共有可能)との合計です。

共有可能 プロセスが使用する物理メモリ内で他のプロセスと共有可能なメモリです。

プライベート プロセスが使用する物理メモリ内で他のプロセスと共有不可能なメモリです。

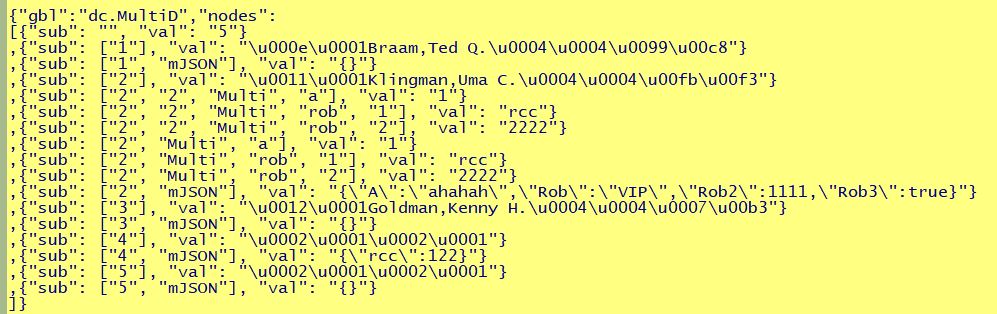

例えば、以下のようにメモリを使用しているプロセスがある場合、ほとんどは共有メモリになっているといえます。

プロセスがアクセスする共有メモリは、データベースキャッシュおよびルーチンキャッシュで使用されているメモリ領域になります。

プロセスが大量にグローバルへのアクセスを行うと、データベースキャッシュへのアクセス量も多くなり、メモリ使用量の共有可能の数値が大きくなります。

(最大でデータベースキャッシュサイズまで大きくなります)

各プロセスのメモリ使用量のワーキングセットが多くても共有可能の数値が多い場合は特に問題はありません。

共有メモリ領域にマップしてる為にワーキングセットの数値が大きくなっているだけで、別途メモリを使用している状況ではありません。

WRTDMN や GARCOL などのシステムコアプロセスのワーキングセット(メモリ)が肥大化している場合、いずれのプロセスもデータベースキャッシュを大量にアクセスするため、データベースキャッシュのサイズが程度までの数値であれば妥当な値となります。

コアプロセスについては、以下のドキュメントをご覧ください。

コアプロセスについて

あわせて、以下の関連記事も是非ご覧ください。

InterSystems製品のプロセスが使用するメモリ量について 管理ポータルのメモリ関連設定項目について

管理ポータルのメモリ関連設定項目について System routine buffer (# KB) shortage is detected.... のメッセージの意味と対処方法

System routine buffer (# KB) shortage is detected.... のメッセージの意味と対処方法 データベースキャッシュおよびルーチンキャッシュの最適値の設定方法

データベースキャッシュおよびルーチンキャッシュの最適値の設定方法 Windows上での共有メモリの割り当てについて

Windows上での共有メモリの割り当てについて

.png)